Presentaci - PowerPoint PPT Presentation

1 / 69

Title: Presentaci

1

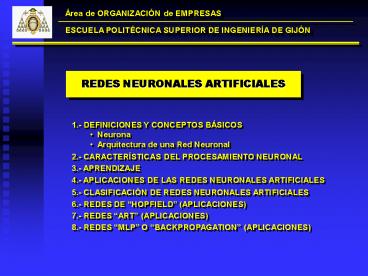

REDES NEURONALES ARTIFICIALES

- 1.- DEFINICIONES Y CONCEPTOS BÁSICOS

- Neurona

- Arquitectura de una Red Neuronal

2.- CARACTERÍSTICAS DEL PROCESAMIENTO NEURONAL

3.- APRENDIZAJE

4.- APLICACIONES DE LAS REDES NEURONALES

ARTIFICIALES

5.- CLASIFICACIÓN DE REDES NEURONALES ARTIFICIALES

6.- REDES DE HOPFIELD (APLICACIONES)

7.- REDES ART (APLICACIONES)

8.- REDES MLP O BACKPROPAGATION (APLICACIONES)

2

1.- DEFINICIONES Y CONCEPTOS BÁSICOS

Sistema de computación que consta de un gran

número de elementos simples, muy interconectados,

que procesan la información respondiendo

dinámicamente frente a unos estímulos externos

(Robert Hetch-Nielsen)

Sistema de procesamiento de infpormación que

consta de un gran número de procesadores simples

y muy interconectados llamados neuronas, que son

análogas a las neuronas biológicas del cerebro

Un grupo de neuronas simuladas, que están muy

interconectadas, al igual que las neuronas del

cerebro, y que son capaces de aprender de la

misma forma que lo hacen los seres humanos

- Elementos individuales de procesamiento o

neuronas - Arquitectura de la red, definida por el

interconexionado de los elementos de procesamiento

3

NEURONA BIOLÓGICA

1015 conexiones

SOMA

AXON

4

NEURONA ARTIFICIAL

5

NEURONA ARTIFICIAL (FUNCIONES DE ACTIVACIÓN)

Función de Activación ESCALÓN

6

NEURONA ARTIFICIAL (FUNCIONES DE ACTIVACIÓN)

Función de Activación LINEAL o IDENTIDAD

7

NEURONA ARTIFICIAL (FUNCIONES DE TRANSFERENCIA)

Función de Activación LINEAL MIXTA

8

NEURONA ARTIFICIAL (FUNCIONES DE ACTIVACIÓN)

Función de Activación SIGMOIDAL

9

NEURONA ARTIFICIAL

10

ARQUITECTURA DE UNA RED NEURONAL

11

2.- CARACTERÍSTICAS DEL PROCESAMIENTO NEURONAL

- Paralelismo Masivo

- Memoria Asociativa Distribuida

- Tolerancia a Fallos

- Tratamiento simultáneo de grandes cantidades de

información - Reconstrucción de Datos Parciales

- Aprendizaje

Características de los problemas que se pueden

resolver con Redes Neuronales Artificiales

- Las tecnologías tradicionales no sirven

- Los datos de entrada son incompletos, variables o

con ruido - Se dispone de un elevado número de ejemplos

resueltos que servirán para entrenar a la red - El proceso de razonamiento que lleva a la

solución del problema es muy complejo o

desconocido sólo se conoce la relación

causa/efecto pero no la heurística de la solución

12

3.- APRENDIZAJE

En las RN la información no se almacena en un

emplazamiento físico único sino que aparece

distribuida por toda la estructura de la red,

concentrándose en los pesos de las uniones de los

distintos elementos. El aprendizaje es el proceso

iterativo por el cual la red modifica sus pesos

como respuesta a una información de

entrada. Proceso de aprendizaje en las redes

neuronales biológicas. Creación y destrucción de

enlaces entre neuronas. Aprendizaje en Redes

Neuronales Artificiales. Pesos con valor 0 o

distintos de 0. El proceso de aprendizaje se

considera terminado cuando los pesos permanecen

estables

13

3.- APRENDIZAJE

- TIPOS DE APRENDIZAJE

- En función de la existencia o no de un agente

supervisor del entrenamiento - Aprendizaje SUPERVISADO

- Aprendizaje NO SUPERVISADO

- En función del orden temporal de las fases de

entrenamiento y utilización de la red - Aprendizaje ON-LINE

- Aprendizaje OFF-LINE

14

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO

- Implica la existencia de un agente externo

(supervisor) que determina la respuesta que la

red debería generar a partir de determinada

entrada. Se comprueba la salida que proporciona

la red y si no coincide con la deseada se

procederá a modificar los pesos de las conexiones - Aprendizaje POR CORRECCIÓN DE ERROR

- Aprendizaje POR REFUERZO

- Aprendizaje ESTOCÁSTICO

15

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR CORRECCIÓN DE ERROR

Consiste en ajustar los pesos de las conexiones

de la red en función de la diferencia entre los

valores deseados y los proporcionados en la

salida de la red. Un ejemplo sencillo es la REGLA

DELTA

Para N neuronas de salida y P ejemplos de

entrenamiento, se puede calcular una medida de

error global

16

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR CORRECCIÓN DE ERROR

Para redes con más de dos capas se puede

generalizar la REGLA DELTA en el algoritmo de

RETROPROPAGACIÓN DEL ERROR o ERROR BACKPROPAGATION

Representa la modificación que hay que hacer en

la entrada que recibe la neurona k

17

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR CORRECCIÓN DE ERROR

Para redes con más de dos capas se puede

generalizar la REGLA DELTA en el algoritmo de

RETROPROPAGACIÓN DEL ERROR o ERROR BACKPROPAGATION

El error dj se calcula en función del error

cometido en las neuronas que reciben como entrada

la salida de j

18

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR CORRECCIÓN DE ERROR

En resumen

Si j es neurona de salida

Si j es neurona de la capa oculta

19

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR CORRECCIÓN DE ERROR

ERROR BACKPROPAGATION WITH MOMENTUM

20

3.- APRENDIZAJE

APRENDIZAJE SUPERVISADO POR REFUERZO

- Durante el entrenamiento no se indica exactamente

la salida que se desea ante una determinada

entrada. La función del supervisor se reduce a

indicar mediante una SEÑAL DE REFUERZO si la

salida de la red se ajusta a lo deseado (1), o

DE PENALIZACIÓN (-1) en caso contrario. - LINEAR REWARD-PENALTY ALGORITHM (LR-P algoritmo

lineal de recompensa y penalización) - ASSOCIATIVE REWARD-PENALTY ALGORITHM (AR-P

algoritmo asociativo de recompensa y penalización)

21

3.- APRENDIZAJE

APRENDIZAJE ESTOCÁSTICO

Se trata básicamente de realizar cambios

aleatorios en los valores de los pesos de las

conexiones de la red y evaluar su efecto a partir

del objetivo deseado y de distribuciones de

probabilidad. Analogía a la termodinámica. Se

asocia la RN con un sólido físico que tiene

cierto estado energético. Se tiende a un estado

de mínima energía que en la red corresponde a una

situación de los pesos con los que se tenga la

salida deseada. El aprendizaje consiste en

realizar un cambio aleatorio de los pesos y

determinar la energía de la red si es menor se

acepta el cambio, y si fuera mayor, se aceptaría

en función de determinada distribución de

probabilidad, con el objetivo de salir de mínimos

locales en busca de el mínimo global (RECOCIDO O

TEMPLE SIMULADO).

22

3.- APRENDIZAJE

APRENDIZAJE NO SUPERVISADO

No requieren de influencia externa para ajustar

los pesos de las conexiones entre sus neuronas.

Las redes presentan la capacidad de

AUTOORGANIZACIÓN. Se buscan las categorías,

regularidades, correlaciones que se pueden

establecer entre los datos que se presentan en la

entrada. En algunos casos, la salida representa

el grado de simulitud y en otros se trata de

hacer una clasificación o clustering a través

de lo que se denomina MAPEO DE CARTERÍSTICAS.

- Aprendizaje HEBBIANO

- Aprendizaje COMPETITIVO Y

- COOPERATIVO

23

3.- APRENDIZAJE

APRENDIZAJE HEBBIANO

Hebb (1949) Cuando un axón de una neurona A

excita repetidamente a una neurona B, algún

proceso o cambio metabólico tiene lugar en ambas

neuronas, de forma que la eficiencia de A aumenta

cuando se trata de excitar a B.

El aprendizaje se basa en el cambio de los pesos

de acuerdo con la correlación de los valores de

activación (salidas) de dos neuronas conectadas,

la unión se refuerza si las dos neuronas tienen

la misma activación, y se debilita si tienen

activación contraria

24

3.- APRENDIZAJE

APRENDIZAJE COMPETITIVO Y COOPERATIVO

Cuando se presenta a la red cierta información de

entrada, se produce una COMPETICIÓN entre todas

las neuronas de la capa de salida por activarse

una de ellas será la VENCEDORA y se activará,

quedando anuladas el resto de las neuronas de la

capa de salida.

El objetivo de este aprendizaje es categorizar

(clusterizar o clasificar por categorías), las

informaciones que se presentan a la red.

Informaciones similares activarán la misma

neurona (o neuronas muy próximas) y por tanto se

clasificarán en la misma categoría.

25

4.- APLICACIONES DE LAS REDES NEURONALES

ARTIFICIALES

- Clasificación de Patrones

- Sistemas de Decisión

- Procesado de Señales (filtrado, codificación)

- Lenguaje Natural

- Visión Artificial (OCR)

- Control en Tiempo Real

- Predicción

RESOLUCIÓN DE PROBLEMAS COMPLEJOS DE CLASIFICACIÓN

- Problemas NP-HARD

- Problema del Viajante (TSP)

- Múltiple TSP

- Bipartición de Grafos

- Problema de la Mochila

- Problema del Calendario de la NHL

RESOLUCIÓN DE PROBLEMAS COMPLEJOS DE OPTIMIZACIÓN

26

5.- CLASIFICACIÓN DE LAS REDES NEURONALES

ARTIFICIALES

RED DE HOPFIELD

REDES OFF-LINE

RED BAM

REDES FEEDBACK

RED ART-1

REDES ON-LINE

RED ART-2

FUNCIÓN DE ACTIVACIÓN LINEAL

PERCEPTRON

MLP PERCEPTRON MULTICAPA

REDES FEEDFORWARD

APRENDIZAJE SUPERVISADO

FUNCIÓN DE ACTIVACIÓN NO LINEAL

SOM MAPA AUTOORGANIZADO DE KOHONEN

APRENDIZAJE NO SUPERVISADO

27

6.- REDES DE HOPFIELD

Wij Wji

28

6.- REDES DE HOPFIELD

29

6.- REDES DE HOPFIELD (FUNCIONAMIENTO)

Es una red AUTOASOCIATIVA Durante la

fase de entrenamiento, se almacenan en la red

varias informaciones codificadas (vectores de 1 y

0, con tantas componentes como neuronas tenga la

red). Posteriormente si se presenta en la entrada

una de las informaciones almacenadas, la red

evoluciona hasta estabilizarse ofreciendo en la

salida la información almacenada que coincide con

la de la entrada. Si la información que se

introduce en la entrada no coincide con ninguna

de las almacenadas (por ejemplo por estar

distorsionada o incompleta), después de

evolucionar, la red proporcionará en la salida la

información previamente almacenada, que más se

parece a la de la entrada.

Matemáticamente

- En el instante inicial (t0), se aplica la

información de entrada (e1, e2, , eN), y la

salida de cada neurona coincide con esa

información

30

6.- REDES DE HOPFIELD (FUNCIONAMIENTO)

- La red realiza iteraciones hasta alcanzar la

convergencia (hasta que la salida en t1 coincide

con la salida en t)

donde f() es la función de activación de las

neuronas (función escalón)

31

6.- REDES DE HOPFIELD (APRENDIZAJE)

Aprendizaje OFF-LINE. Se fijan los valores de los

pesos de los enlaces en función de las

informaciones que se desea almacenar en la

red. Se trata de un aprendizaje NO SUPERVISADO,

de tipo HEBBIANO el peso de la conexión entre

las neuronas i y j se obtiene mediante el

producto de las componentes i-ésima y j-ésima

del vector que representa la información que se

desea almacenar. Si se deben aprender M

informaciones, el peso Wij será la suma de los

productos de sus componentes

32

6.- REDES DE HOPFIELD (APRENDIZAJE)

Matricialmente

33

6.- REDES DE HOPFIELD (APRENDIZAJE)

Ejemplo de aprendizaje y funcionamiento de una

red de Hopfield supongamos que se desea

memorizar dos informaciones E1 y E2

34

6.- REDES DE HOPFIELD (APRENDIZAJE)

35

6.- REDES DE HOPFIELD (APRENDIZAJE)

36

6.- REDES DE HOPFIELD (APRENDIZAJE)

37

6.- REDES DE HOPFIELD (APRENDIZAJE)

38

6.- REDES DE HOPFIELD (ANALOGÍA ENERGÉTICA)

Se puede calcular una FUNCIÓN DE ENERGÍA que

representa los posibles estados de la red como

puntos de un espacio N-dimensional

Cuando en una red se han almacenado M

informaciones, los posibles estados estables son

M, y corresponden con los mínimos de la función

de energía. Cuando se presenta en la entrada una

nueva información, la red evolucionará hasta

alcanzar un mínimo de la función de

energía. Esta característica se utiliza en la

utilización de la redes de Hopfield para resolver

problemas de optimización.

39

6.- REDES DE HOPFIELD (APLICACIONES)

- Reconocimiento de imágenes (ejemplo anterior)

- Resolución de problemas de optimización

Se fija el objetivo del problema mediante una

función matemática (función de coste), que se

debe minimizar. Se compara esta función de coste

con la función de energía de la red de Hopfield,

determinándose así los valores de los pesos Wij y

de los umbrales de activación Ui, en términos de

los parámetros de la función objetivo para que

ambas expresiones sean equivalentes. Al poner

la red en funcionamiento, la red evoluciona hasta

alcanzar un mínimo de su función de energía, lo

cual implica minimizar la función objetivo.

40

6.- REDES DE HOPFIELD (APLICACIONES)

Problema del viajante de comercio (TSP)

41

6.- REDES DE HOPFIELD (APLICACIONES)

Problema del viajante de comercio (TSP)

Función de coste

42

6.- REDES DE HOPFIELD (APLICACIONES)

Problema del viajante de comercio (TSP)

Se relaciona con la expresión general de la

FUNCIÓN DE ENERGÍA de Hopfield para calcular los

pesos

43

6.- REDES DE HOPFIELD (APLICACIONES)

Problema de BIPARTICIÓN DE GRAFOS

44

6.- REDES DE HOPFIELD (APLICACIONES)

Problema de BIPARTICIÓN DE GRAFOS

Función de coste

45

6.- REDES DE HOPFIELD (APLICACIONES)

Problema de BIPARTICIÓN DE GRAFOS

46

7.- REDES ART

Memoria Humana es capaz de aprender cosas nuevas

sin olvidar necesariamente lo aprendido en el

pasado. Dilema de la ESTABILIDAD y

PLASTICIDAD Cómo puede un sistema ser adaptable

(PLÁSTICO) en respuesta a una entrada

significativa y permanecer ESTABLE ante una

entrada irrelevante. Cómo puede un sistema

alternar entre los modos PLÁSTICO y ESTABLE. Cómo

puede un sistema retener la información aprendida

antes y seguir aprendiendo informaciones

nuevas. En respuesta a todo esto se desarrolló

la TEORÍA DE RESONANCIA ADAPTATIVA (ART) por

parte de Carpenter y Grossberg, y como resultado

tenemos las redes ART

47

7.- REDES ART

48

7.- REDES ART

Las redes ART son un ejemplo de redes neuronales

ON-LINE, con aprendizaje NO SUPERVISADO,

COMPETITIVO. ART-1 trabaja con entradas y

salidas binarias (0 y 1). ART-2 entradas y

salidas reales

E1 ( 0 , 1 , 1 , 0 , 1 ) E2 ( 0 , 0 , 1 , 0 ,

1 ) E3 ( 1 , 1 , 0 , 1 , 0 ) . . . .

. . .

49

7.- REDES ART

El algoritmo se puede resumir en los 8 pasos

siguientes (Lippmann, 1987) PASO 1.

Inicialización de los pesos y elección de CS

PASO 2. Presentación a la red de un vector de

entradas X (N elementos 0/1)

50

7.- REDES ART

PASO 3. Cálculo de la señal de activación µj de

las neuronas de la capa de salida

PASO 4. Selección de la neurona de mayor

activación µ? que representa al patrón T? de la

categoría elegida (en caso de haber varias con la

misma activación, se escogerá la de menor índice)

51

7.- REDES ART

PASO 5. Test de Similitud con el patrón de la

categoría seleccionada

Ir al PASO 7 en caso contrario ir al PASO 6

Si

PASO 6. Inhabilitar temporalmente el patrón de

la categoría escogida. Ahora se vuelve al PASO 3

para elegir el patrón representativo de otra

categoría.

52

7.- REDES ART

PASO 7. Actualización del patrón de la categoría

para que represente al nuevo vector que se ha

clasificado como perteneciente a la categoría

PASO 8. Repetir hasta terminar todas las

entradas que se desea clasificar ir al PASO 2,

después de habilitar todos los patrones

inhabilitados en el paso 6.

53

7.- REDES ART (APLICACIONES)

Formación de celdas trabajo-máquina 25

piezas 15 máquinas

54

7.- REDES ART (APLICACIONES)

55

7.- REDES ART (APLICACIONES)

56

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

bij 1 2 3

0 1/4 1/4 1/4

1 1/4 1/4 1/4

2 1/4 1/4 1/4

tji 1 2 3

0 1 1 1

1 1 1 1

2 1 1 1

57

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

58

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

59

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

60

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

bij 1 2 3

0 1/2.5 1/4 1/4

1 1/2.5 1/4 1/4

2 0 1/4 1/4

tji 1 2 3

0 1 1 1

1 1 1 1

2 0 1 1

61

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

62

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

63

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

64

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

bij 1 2 3

0 1/2.5 1/2.5 1/4

1 1/2.5 0 1/4

2 0 1/2.5 1/4

tji 1 2 3

0 1 1 1

1 1 0 1

2 0 1 1

65

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

66

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

67

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

68

7.- REDES ART (APLICACIONES)

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

Máquinas i

bij 1 2 3

0 1/2.5 0 1/4

1 1/2.5 0 1/4

2 0 1/1.5 1/4

tji 1 2 3

0 1 0 1

1 1 0 1

2 0 1 1

69

7.- REDES ART (APLICACIONES)

Piezas j

Piezas j

1 2 3

0 1 1 0

1 1 0 0

2 0 1 1

1 2 2 3

0 1 1 0 0

1 1 0 0 0

2 0 0 1 1

Máquinas i

Máquinas i